Jeg har altid været fan af split tests og automatisering. Men hvor jeg i høj grad har benyttet automatisering, så har jeg desværre ikke split testet nær så ofte, som jeg burde. Når jeg har testet, så har det været tests som jeg 100% selv har bygget op. Jeg har derfor aldrig benyttet nogle af de mange tools der findes til netop split testing.

Jeg har netop lavet en ændring på en af mine sider, som jeg gerne vil have split testet. Jeg har derfor valgt at benytte et tool til dette, og jeg tænkte i første omgang på Visual Website Optimizer, da jeg har hørt mange gode ting om dette værktøj. Jeg signede derfor op til en konto. Ved angivelsen af min første split test blev der linket til en introduktionsvideo, og denne video fik mig til at droppe dette værktøj i denne omgang. Mit indtryk via denne video er at Visual Website Optimizer er super god til små ændringer. Disse ændringer kan man lave direkte i Visual Website Optimizer og skal derfor ikke ændre noget på sin side. Til gengæld virker det noget uoverskueligt (måske endda umuligt) hvis man vil lave større ændringer, hvor man ændrer i den bagvedliggende kode, for at teste 2 vidt forskellige resultater.

Har du erfaringer med Visual Website Optimizer, så lad mig endelig høre om du har samme indtryk?

Google Analytics Eksperimenter

Jeg søgte derfor på Google efter andre split test værktøjer, og her stødte jeg på split testing direkte i Google analytics, også kaldet Google Analytics Eksperimenter. Google har tidligere på året valgt at lukke deres Google Website Optimizer og lade det erstatte af Google Analytics Eksperimenter. Jeg har endnu kun få erfaringer med “Eksperimenter” men indtil videre virker det som et rigtig godt tool.

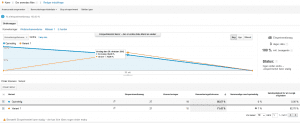

Jeg har opsat et eksperiment på en underside, som dagligt har 20-30 besøgende. Der kommer derfor til at gå noget tid inden jeg har et validt resultat. Jeg vil ikke nævne den specifikke side, da eksperimentet fortsat er i gang, og jeg ønsker ikke at påvirke resultatet via besøgende fra denne blog. Eksperimentet skal naturligvis være på “naturlige” besøgende. Eksperimentet har indtil videre kørt i 1,5 døgn, og resultatet ser sådan ud:

Eksperimentet blev startet om aftenen den 29/10-2012. Her nåede der kun at komme 2 besøgende, og samlet 1 konvertering, hvilket gav 100 % succes på den oprindelige og 0 % på varianten. Næste dag blev varianten vinder med 75% succes imod 65% succes til den oprindelige version. Dette er pt. den eneste hele dag i testen og derfor første indikation på det endelige resultat.

Umiddelbart virker det meste i Google Analytics Eksperimenter meget intuitivt. Der var dog 3 ting som jeg ikke kunne finde svar på direkte hos Google. Jeg har fundet svar på den første via en Google søgning, og Morten Vadskær har givet mig svaret på de sidste via kommentarerne:

Spørgsmål: Hvordan frasorterer man sine egne besøg, så de ikke påvirker testen?

Svar: Eksperimentet bruger samme filtre som selve Analytics kontoen. Da jeg allerede har et filter i Analytics der frasorterer besøgende fra min IP-adresse, så har mine besøg altså heller ikke indflydelse på testen.

Spørgsmål: Hvorfor har mit eksperiment givet 27 besøg på den oprindelige, og 21 besøg på varianten. Burde det ikke være mere ligeligt fordelt?

Svar: Hvilken side der vises udvælges tilfældigt, uanset hvilken side der tidligere har været vist. I det lange løb burde der være stort set lige mange visninger på begge varianter.

Spørgsmål: Der bliver angivet antal af konverteringer, men er det antallet af besøgende der har lavet en konvertering, eller er det antallet af samlede konverteringer? Samme bruger kan godt lave mere end én konvertering, og derfor er de 2 tal sandsynligvis ikke ens.

Svar: Der vises antal af besøgende der har lavet en konvertering, og IKKE det samlede antal konverteringer.

Har du endnu ingen erfaringer med Google Analytics Eksperimenter, så håber jeg at du har fundet inspiration i ovenstående indlæg.

Har du til gengæld erfaringer med Google Analytics Eksperimenter, så spred gerne dine tips og tricks via kommentarerne herunder. De vil blive værdsat ;-)

Mht fordelingen, så er det aldrig “en til dig. En til mig”-princippet, det bliver fordelt med. Det udligner sig og er uden stor betydning for statistikken på langt sigt.

En bruger, der laver flere konverteringer tæller kun med en gang. Det kunne jo være, at ham, der fik en blå knap er stamkunde eller stor-kunde og handler flere gange om dagen og i sådan et tilfælde ville han kunne påvirke testen helt vanvittigt. Derfor tæller han kun en gang.

Jeg har kun startet et par tests med Google Analytics eksperimenter og sidder og håber på, at de snart inkluderer multivariant tests.

Held og lykke med split-testen

Fantastisk Morten, tak for svar.

Du har ret i at antal brugere med konverteringer giver mere mening end det samlede antal konverteringer. Men jeg kunne nu alligevel godt tænke mig at se begge tal. Det kan man jo andre steder i Google. Jeg kan ikke huske om det er tilfældet i Analytics, men man kan i hvert fald i Adwords.

Du kan vel se det i rapporten for den enkelte side. Måske lidt oldnordisk, men det er en måde at se det på

Det kan jeg ikke for jeg har valgt i testen at besøg på varianten skal tælle som besøg på den oprindelige side i Analytics. Lidt kringlet sætning, men jeg kan ikke huske det officielle navn for det.